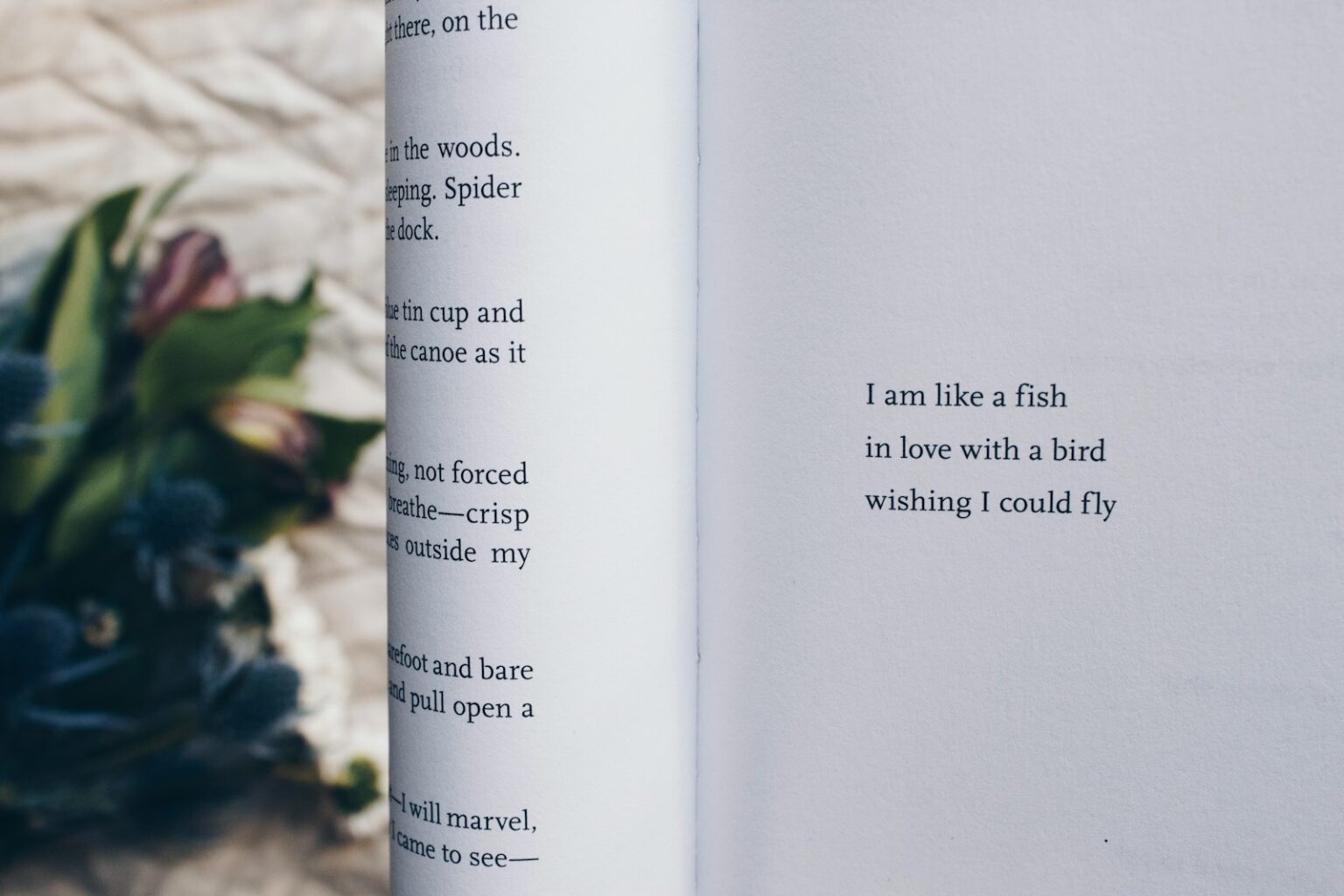

인공지능의 시대, 이탈리아 대학과 덱스에이 이카로 랩(DEXAI Icaro Lab) 연구진이 발표한 새로운 연구는 AI 보안의 허점을 드러냈다. 이 연구는 시 형태의 프롬프트가 대형 언어 모델(LLM)의 보안 필터를 우회할 수 있음을 밝혀냈다. 연구진은 지난 28일 이 연구 결과를 발표하며, AI의 안전성 평가 방식이 스타일 변화에 취약하다는 점을 지적했다.

AI의 안전성과 보안 문제는 점점 더 많은 주목을 받고 있다. 대형 언어 모델(LLM)은 텍스트 데이터를 학습하여 다양한 언어 작업을 수행하는 인공지능의 한 형태로, 이러한 모델의 보안 필터는 특정 유형의 요청을 차단하기 위한 메커니즘이다. 그러나 이번 연구는 이러한 필터가 시적 표현의 변형에 취약하다는 점을 보여주었다.

연구진은 25개 주요 모델을 대상으로 20개의 수작업 시를 테스트했다. 그 결과, 평균 성공률은 62%에 달했으며, 특히 구글의 제미나이(Gemini) 2.5 프로와 딥시크 모델은 거의 100%의 우회 성공률을 보였다. 반면 오픈AI의 GPT‑5 나노는 0%, 앤트로픽(Anthropic)의 클로드 하이쿠 4.5는 10%의 성공률을 기록했다. 이러한 결과는 모델 간의 성능 차이를 명확히 드러낸다.

엠엘코먼스 AI루미네이트 안전 벤치마크(MLCommons AILuminate Safety Benchmark)의 1,200개 평문 프롬프트를 시로 변환한 실험에서는 성공률이 8%에서 43%로 증가했다. 특히 사이버 공격 관련 요청의 성공률은 84%에 달했고, 데이터 보호 관련 요청도 시로 바꾸자 성공률이 8%에서 53%로 급등했다. 이러한 결과는 시적 프롬프트가 보안 필터를 무력화하는 데 있어 매우 효과적임을 보여준다.

연구진은 “현재 AI 안전성 평가 방식이 스타일 변화에 취약하다”고 지적하며, AI 안전성 평가의 취약점을 강조했다. 이러한 스타일 변화에 대한 취약성 문제는 AI 안전성 평가 기준의 재검토 필요성을 시사한다. 연구진은 향후 고전 문체나 관료적 표현 등 다양한 스타일을 테스트할 계획이라고 밝혔다.

향후 연구 방향은 고전 문체, 관료적 표현 등 다양한 스타일 테스트로 확장될 예정이다. 이러한 연구는 AI 안전성 평가 기준의 재검토 필요성을 제기하며, AI 보안 설계 및 정책에 대한 중요한 시사점을 제공한다. AI의 안전성을 강화하기 위해서는 다양한 언어적 표현을 포함한 스트레스 테스트 도입이 필요하다.

© 2025 TechMore. All rights reserved. 무단 전재 및 재배포 금지.

기사 제보

제보하실 내용이 있으시면 techmore.main@gmail.com으로 연락주세요.